Meta представила семейство моделей Llama 4, включая Scout и Maverick — AI-системы нового поколения с поддержкой мультимодальности, уникальной длиной контекста — до 10 млн токенов — и архитектурой Mixture-of-Experts.

Модели уже доступны для загрузки и опережают конкурентов по ряду метрик, включая производительность и мультиязычность.

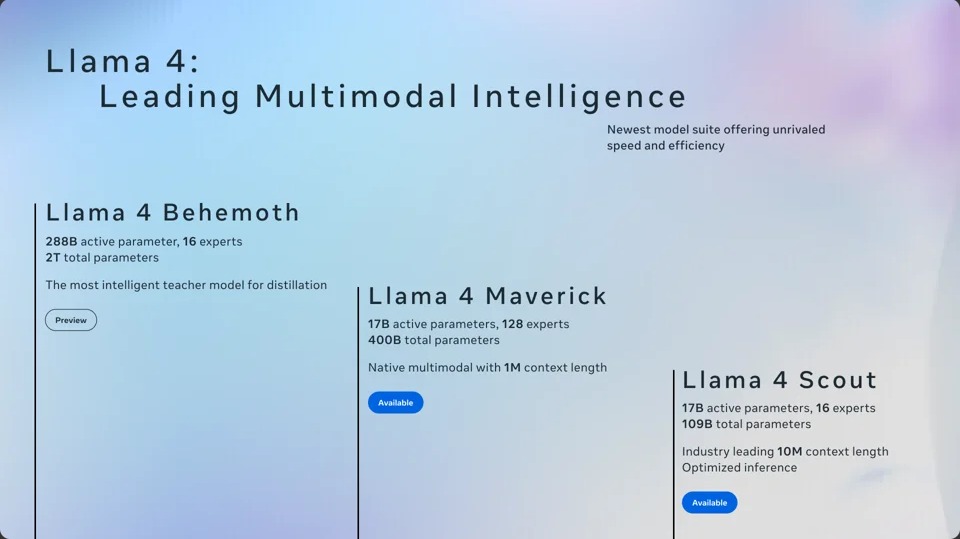

Что представила Meta: ключевые модели Llama 4

Meta представила две версии Llama 4, заточенные под разные задачи.

Llama 4 Scout:

17 млрд активных параметров и 16 экспертов;

контекстное окно до 10 миллионов токенов — одна из самых длинных последовательностей в индустрии;

поддерживает многодокументные резюме, анализ больших пользовательских потоков и сложные логи;

эффективен в работе с длинным контекстом и персонализированными ассистентами.

Llama 4 Maverick:

также 17 млрд параметров, но уже 128 активных экспертов, что увеличивает способность к параллельной обработке;

лучшие показатели в обработке изображений и текста, включая генерацию, классификацию и анализ визуальных данных;

подходит для широкого спектра задач: от чат-ботов до аналитических платформ с мультимодальной поддержкой;

в тестах показывает производительность выше GPT-4o, сохраняя баланс между качеством и вычислительными затратами.

Обе модели используют архитектуру Mixture-of-Experts (MoE), в которой активируются только определенные части модели при каждом запросе. Это снижает затраты и увеличивает масштабируемость.

Данные и языки:

обучение на 30+ триллионах токенов;

поддержка 200 языков, включая редкие;

интеграция визуальных и текстовых данных через механизм раннего объединения (early fusion).

Технологии:

MetaP — инструмент для автоматической настройки гиперпараметров;

новые методы объединения текста и изображений на уровне обучения;

механизмы улучшенной генерации ответов и логических цепочек.

Еще более мощная Llama 4 Behemoth с 288 млрд параметров, уже показывает высокие результаты в технических дисциплинах (STEM). Пока что модель находится на обучении, но вскоре также станет доступной.

Постобработка, улучшения качества и безопасность

После предварительного обучения Meta применила улучшенную стратегию дообучения:

SFT (supervised fine-tuning) — ручная донастройка по размеченным данным;

RL (reinforcement learning) — обучение с подкреплением для повышения качества диалогов;

DPO (direct preference optimization) — оптимизация по предпочтениям пользователей.

Эти методы обеспечили улучшение в кодинге, логике и диалогах. Результаты лучше сбалансированы по различным типам задач, от технических вопросов до общения в стиле чат-ассистентов. Кроме того, Meta делает особый акцент на безопасность:

встроенные инструменты Llama Guard и Prompt Guard предотвращают генерацию токсичных, вредных или чувствительных ответов;

снижена предвзятость в темах, связанных с политикой, этикой, а также идентичностью;

реализована система многоуровневых фильтров, действующих на этапе как обучения, так и вывода.

Кроме того, Meta анонсировала конференцию LlamaCon, где подробно расскажет о применении моделей, интеграции и будущем экосистемы.

Чем полезны Llama 4 разработчкикам и командам?

Разработчикам будет крайне полезной быстрая интеграция, экономия ресурсов и гибкость мультимодальности. Теперь можно строить сложные приложения с текстом и изображениями.

В свою очередь, для AI-команд и продуктов будут актуальными длинный контекст с углубленным анализом доументов и логов, а также поддержка 200 языков для глобальных продуктов.

👉🏻Следите за новостями в нашем telegram-канале — Новости Арбитража.

Нет комментариев.